Число игроков на российском рынке, развивающих собственные большие языковые модели (LLM), продолжает увеличиваться. Свою первую языковую модель с гибридным режимом рассуждений — T-Pro 2.0 представила группа «Т-Технологии» (дочка «Т-Банка»). Платформа входит в семейство моделей Gen-T. «Т-банк» планирует использовать новую модель для повышения качества работы своих ИИ-ассистентов, доступных всем клиентам банка, а также для повышения эффективности операционных процессов за счёт интеграции автономных агентов.

Новая модель обеспечивает более высокое качество ответов на сложные запросы при двукратной экономии вычислительных ресурсов для русскоязычных задач по сравнению с аналогами Qwen3 и DeepSeek R1-Distil.

Гибридные модели способны в зависимости от запроса выбирать между быстрыми, простыми ответами и глубоким анализом, что снижает затраты на вычисления при внедрении ИИ. По данным «Т-Технологий», расходы на разработку модели, включая затраты на вычислительные мощности для R&D и финального дообучения, а также зарплаты сотрудников, не превышают 120 млн рублей.

Такие модели лучше справляются со сложными аналитическими задачами, что позволяет использовать их в качестве основы для ИИ-агентов нового поколения, способных выполнять задачи без вмешательства человека. Например, в службе поддержки ИИ-агенты не просто помогают генерировать ответы, но и самостоятельно решают часть пользовательских запросов. В «Т-банке» доля таких обращений уже составляет 40 %.

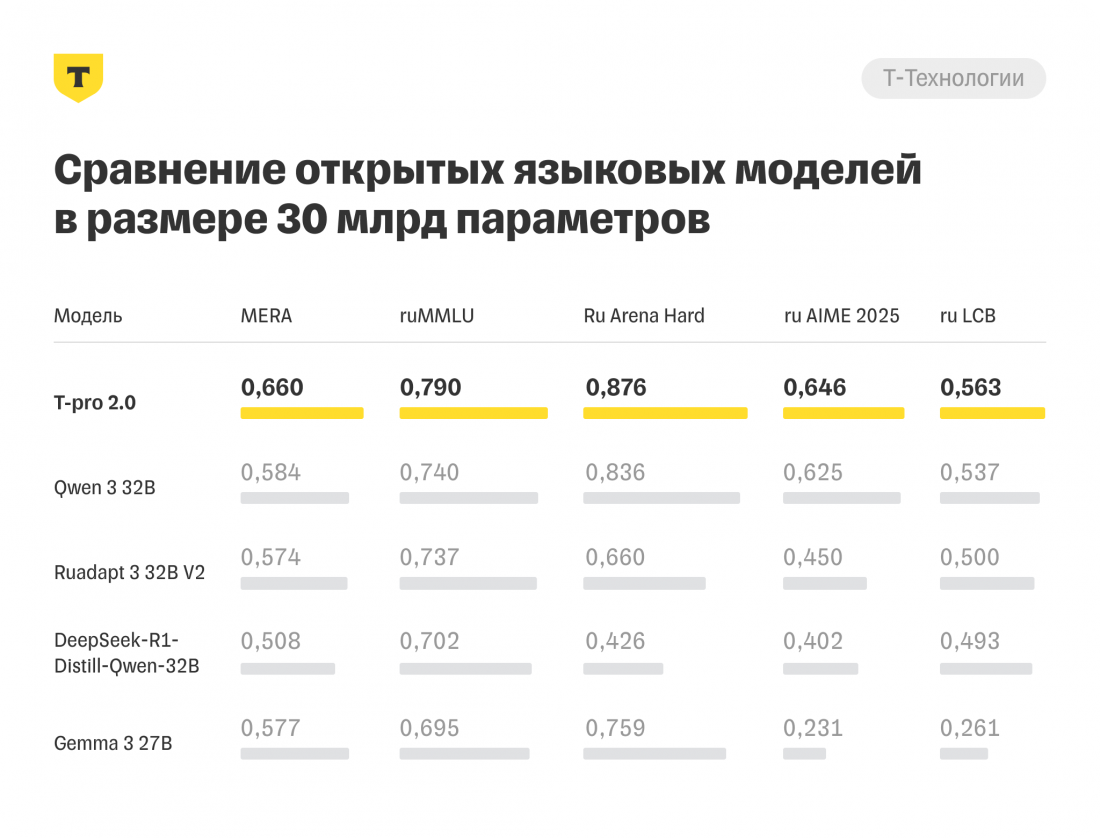

Согласно данным «Т-Технологий», модель T-Pro 2.0 продемонстрировала более высокие результаты на русскоязычных бенчмарках — MERA, ruMMLU, Ru Arena Hard, ruAIME, ruLCB — по сравнению с другими открытыми моделями на 30 млрд параметров.

Модель T-Pro 2.0 с числом параметров 32 млрд находится в открытом доступе на платформе Hugging Face под лицензией Apache 2.0.